在当今大数据时代,MongoDB以其灵活的文档模型、强大的横向扩展能力和高性能,成为处理海量数据的流行选择。当数据量达到上亿甚至数十亿级别时,系统的性能、稳定性和扩展性将面临严峻考验。此时,合理的计算机硬件与网络设备配置,不再是简单的资源堆砌,而是决定系统成败的关键工程决策。本文将深入探讨在此场景下的核心配置考量。

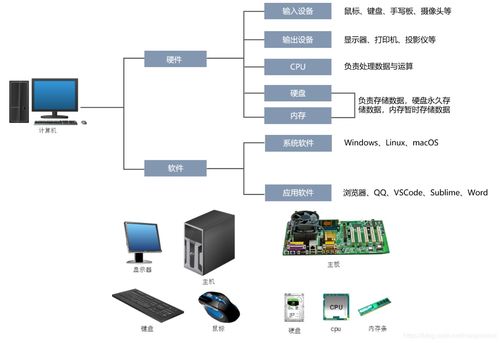

一、 计算机硬件配置策略

处理上亿级数据的MongoDB集群,其硬件配置需围绕I/O、内存、CPU和存储四大核心展开。

1. 存储子系统:速度与容量的平衡

* 硬盘类型:必须使用固态硬盘。机械硬盘的随机I/O性能无法满足高并发读写需求,是性能的最大瓶颈。推荐使用企业级NVMe SSD,以获得极低的延迟和极高的IOPS。

- 存储配置:强烈建议将数据存储、日志存储和操作系统分置于不同的物理磁盘或逻辑卷上,避免I/O争用。对于WiredTiger存储引擎,其数据压缩特性可节省空间,但计算本身会消耗少量CPU。

- RAID级别:通常采用RAID 10,它在提供出色读写性能的通过镜像保障了数据安全。避免使用RAID 5/6,因其写入性能较差。

2. 内存:越大越好,但需精打细算

* 工作集原则:内存容量应尽可能覆盖“工作数据集”——即经常被访问的热数据。对于上亿条文档,即使经过索引,工作集也可能达到数百GB。内存不足将导致频繁的磁盘换入换出,性能急剧下降。

- 分配策略:为MongoDB进程分配充足内存,同时为操作系统文件缓存预留空间(通常占物理内存的20%-30%)。监控

wiredTiger cache的命中率是评估内存是否充足的关键指标。

3. CPU:多核与高主频并重

* 多核并行:MongoDB的查询、聚合、索引构建及复制集同步等操作都能利用多核。建议选择核心数较多的CPU(如16核以上)。

- 时钟频率:更高的主频对单线程操作(如某些聚合管道阶段)有益。需根据实际负载特点(是大量简单查询还是复杂分析)在核心数与主频间取得平衡。

4. 网络接口:每台服务器应配备万兆(10GbE)或更高速率的网络接口卡。集群内部节点间(分片间、副本集成员间)的数据同步、心跳检测、查询路由(mongos)会产生巨大的网络流量,千兆网络极易成为瓶颈。

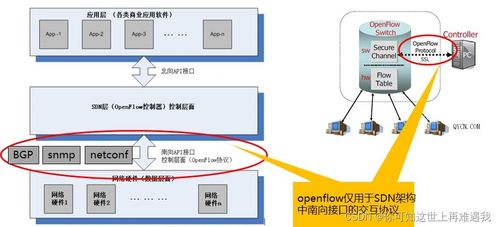

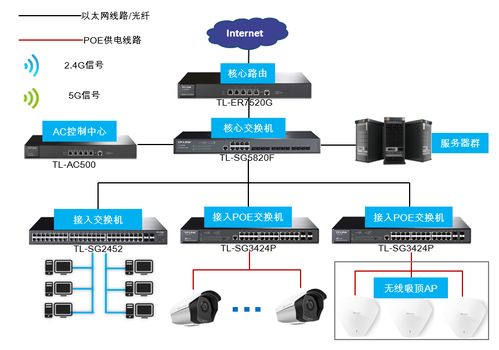

二、 网络设备与架构设计

强大的单机是基础,但上亿级数据必然依赖分片集群。此时,网络成为连接各个“器官”的“血管系统”。

1. 网络拓扑与延迟

* 低延迟需求:所有MongoDB集群组件(配置服务器、分片节点、mongos路由器)应部署在同一低延迟的数据中心或可用区内。跨地域部署会引入显著网络延迟,严重影响写关注、读偏好和平衡器操作。

- 网络隔离与安全:使用VLAN或私有子网对MongoDB集群流量进行隔离,确保数据同步和内部通信的安全与稳定。通过防火墙严格限制访问源。

2. 网络设备要求

* 交换机性能:核心交换机和接入交换机必须支持全线速万兆转发,且具有足够的背板带宽和包转发率,以应对集群内部突发的大流量数据迁移(块迁移)和同步。

- 冗余与高可用:采用链路聚合和设备堆叠/集群技术,实现网络路径的冗余,避免单点故障导致整个数据库集群不可用。

3. 与应用程序的互联

* 应用服务器连接:应用程序服务器(或API服务器)连接mongos路由器的网络同样需要高带宽、低延迟。多个mongos实例应实现负载均衡。

- 驱动程序配置:在应用端使用最新版本的官方驱动程序,并合理设置连接池大小、超时和读写关注级别,以优化网络利用效率。

三、 配置原则与监控

核心原则:均衡与留有余量。避免出现CPU极强但I/O极弱,或内存巨大但网络吞吐不足的“木桶效应”。所有硬件资源应协同工作,并预留20%-30%的峰值处理余量。

持续监控与调优:硬件配置不是一劳永逸的。必须建立完善的监控体系,持续关注关键指标:

硬件层:磁盘IOPS/延迟、网络带宽/丢包率、CPU负载、内存使用/交换情况。

MongoDB层:操作排队情况、锁竞争、缓存命中率、复制延迟、分片块分布与迁移状态。

通过监控数据,可以及时发现瓶颈,并进行垂直升级(如增加内存、更换更快SSD)或水平扩展(如增加新的分片节点)。

###

处理上亿级数据的MongoDB系统,是一个复杂的系统工程。卓越的硬件与网络设计,是承载其高效、稳定运行的物理基石。它要求架构师不仅深谙MongoDB的内部原理,更要通晓硬件特性与网络知识,在性能、成本与可靠性之间做出精准的权衡,从而构建出能够从容应对海量数据挑战的坚实数据平台。